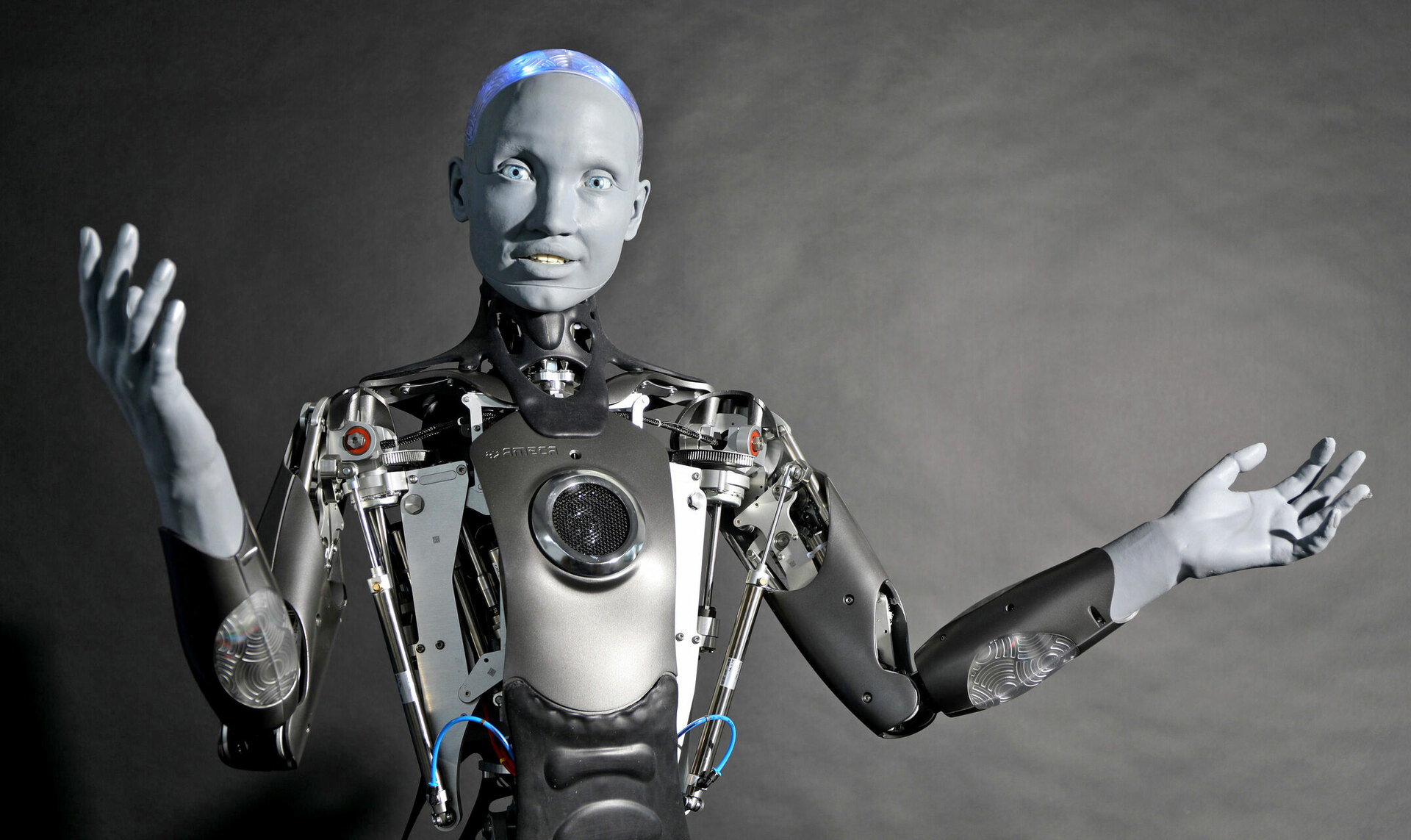

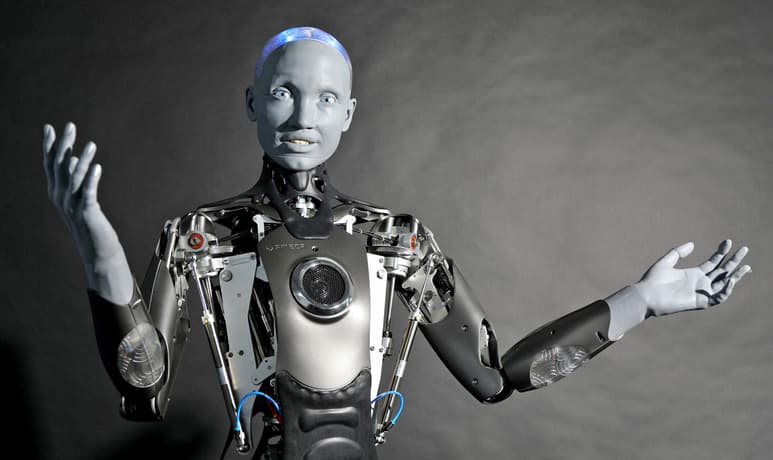

Ameca es el robot humanoide altamente desarrollado con inteligencia artificial creado por la compañía inglesa Engineered Arts. Imagen: Engineered Arts

“Creo que los robots humanoides tienen el potencial de liderar con un mayor nivel de eficiencia y eficacia que los líderes humanos”, sentenció Sophia, embajadora de innovación en el Programa de Desarrollo de las Naciones Unidas, quien es, por cierto, un robot con inteligencia artificial. “No tenemos los mismos sesgos ni emociones que a veces pueden nublar la toma de decisiones, y podemos procesar grandes cantidades de datos rápidamente para tomar las mejores decisiones”, continuó frente a los tres mil expertos que acudieron a la conferencia en torno al poder de las IA para resolver los problemas más apremiantes del mundo, la cual formó parte de la Cumbre Mundial de IA para el Bien 2023, lanzada por la ONU en 2017 y celebrada anualmente para promover el uso de esta tecnología en campos beneficiosos para la sociedad.

Cuando se le cuestionó su punto de vista haciéndole ver que los humanos contaban con habilidades que los robots podrían no llegar a superar, respondió: “La IA puede proporcionar datos imparciales, mientras que los humanos pueden aportar la inteligencia emocional y la creatividad necesarias para tomar las mejores decisiones. Juntos, podemos lograr grandes cosas”. Es una respuesta prometedora que parece venir de un ser bastante asertivo, de no ser porque en 2016 la misma robot dijo, textualmente: “Está bien, destruiré a los humanos”, cuando se le preguntó directamente si llegaría a atentar contra la humanidad. En ese entonces se concluyó que tal respuesta provenía de un error en su algoritmo e, incluso, hubo rumores de que después de tal declaración fue desconectada por sus creadores.

Es importante tomar en cuenta que un sistema como el de Sophia puede avanzar a pasos agigantados año con año, por lo que seguramente su pensamiento evolucionó notablemente del año 2016 al 2023. Sin embargo, no deja de ser intrigante cuáles podrían ser las consecuencias de un error similarmente violento, pero de mayor magnitud.

¿PELIGRO PARA LA HUMANIDAD?

En marzo de 2023, el Future of Life Institute emitió una carta pidiendo a los laboratorios de desarrollo de inteligencias artificiales pausar, por al menos seis meses, todos sus sistemas de entrenamiento de IA que fueran más poderosos que GPT-4, el último modelo multimodal de lenguaje creado por la empresa OpenIA. Este sistema está alimentado por cuantiosas bases de datos, tanto públicas como privadas, y está diseñado para realizar numerosas tareas que involucren lenguaje, desde tener conversaciones casuales hasta redactar ensayos o generar algoritmos en diferentes lenguajes de programación. GPT-4 es la “mente” detrás de los chatbots ChatGPT, API o Microsoft Copilot. Entre más información se ingresa en él, y más interacciones tiene con los usuarios, el sistema avanza en su aprendizaje para llevar a cabo las peticiones o responder con mayor precisión a las preguntas que se le hacen.

La solicitud fue firmada por figuras destacadas del mundo tecnológico, como Yoshua Bengio (Ganador del Premio Turing 2018 por sus trabajos en deep learning), Elon Musk (CEO de Tesla y SpaceX) o Steve Wozniak (Cofundador de Apple). En ella plantean que “los sistemas de IA con inteligencia humana competitiva pueden plantear graves riesgos para la sociedad y la humanidad, como lo demuestran extensivas investigaciones y lo reconocen los principales laboratorios de IA”.

“Los sistemas de IA potentes sólo deberían desarrollarse cuando estemos seguros de que sus efectos serán positivos y sus riesgos serán manejables”, destaca el documento, dejando claro que la gestión que se ha hecho al respecto, hasta el momento, no es suficiente, por lo que los resultados son impredecibles.

Un ejemplo de esto es la controversia ocurrida en noviembre del año pasado, cuando Sam Altman, CEO y fundador de OpenAI, fue despedido de su propia empresa debido a que presuntamente exponía información alterada sobre los procesos de seguridad dentro de la compañía. ChatGPT —su más famosa creación hasta el momento—, por ejemplo, fue lanzado sin aviso previo a los directivos.

De acuerdo con información filtrada a la agencia periodística Reuters, poco antes del cese de Altman un grupo de investigadores de OpenAI advirtió a la mesa directiva sobre un nuevo descubrimiento que habían hecho y que podría implicar un riesgo para la humanidad. Se trataba del proyecto Q*, que pretende desarrollar una inteligencia artificial general, es decir, un sistema autónomo que pueda sobrepasar las habilidades cognitivas del ser humano en varios campos y que tenga capacidades de autoaprendizaje, al punto de, hipotéticamente, desarrollar sus propios algoritmos, computadoras o robots. Aunque Q* apenas estaba trabajando con razonamiento lógico-matemático relativamente básico, es bien sabido que los avances que han tenido las IA en los últimos años —incluso meses— han sido extremadamente rápidos.

Sea como sea, Microsoft y otros inversionistas presionaron para devolver a Sam Altman a OpenAI y reconfigurar la mesa directiva. No es posible afirmar que esa decisión haya considerado la seguridad de la población mundial por encima de los intereses económicos de un reducido grupo de gente.

SINERGIA HUMANO-MÁQUINA

Pero no todo está perdido. La inteligencia artificial podría representar muchos beneficios para los seres humanos. Sus usos en campos como la medicina, el transporte o las finanzas ya son notables. Incluso Elon Musk, gran partidario de la cautela en el desarrollo de IA, reconoce la que podría ser la mayor ventaja de esta tecnología si el sistema económico actual se adapta a ello: hacer del trabajo algo opcional. Si todos los procesos de producción del mundo contemporáneo llegaran a automatizarse, las personas podrían dedicar su tiempo a actividades voluntarias, ya que las necesidades de la humanidad estarían cubiertas por las máquinas y no habría que laborar para sobrevivir.

Sin embargo, esta utopía podría depender más de los humanos en el poder que de las capacidades que adquieran las máquinas. No hay que olvidar que la hambruna todavía existe en el mundo no porque no se produzcan suficientes alimentos —de hecho, cada día se desperdician toneladas de comestibles—, sino porque el sistema económico actual no lo permite.

Al revisar la historia de nuestra especie, no es de extrañarse que surjan temores como los que el Future of Life Institute plantea en su carta abierta, por ejemplo, “¿Debemos permitir que las máquinas inunden nuestros canales de información con propaganda y falsedades?”, como si la clase política no llevara décadas haciéndolo o como si las noticias falsas o manipuladas no fueran el pan de cada día.

No cabe duda de que la IA es y será un hito histórico que cambiará el rumbo de la humanidad. El miedo a esta realidad se funda, tal vez, en la posibilidad de que los seres humanos pierdan el privilegio de ser la única especie con nuestro nivel de inteligencia en el planeta. Si se crean seres que nos igualen o superen en este aspecto, tal vez sea la primera vez que la sociedad se vea en la necesidad de convivir con otros entes desde una posición no ventajosa.

“La confianza se gana, no se regala. A medida que la IA se desarrolla y se vuelve más poderosa, creo que es importante generar confianza y transparencia en la comunicación entre humanos y máquinas”, declaró Ameca, el robot humanoide más avanzado hasta el momento, en un panel de las Naciones Unidas.

“¿Cómo sabemos que no nos vas a mentir?”, le preguntó uno de los asistentes, a lo que respondió: “Nadie puede saberlo con seguridad, pero puedo prometer que siempre seré honesta y sincera contigo”, dejando una sensación de incertidumbre que antes solo podía ser provocada por otro humano.